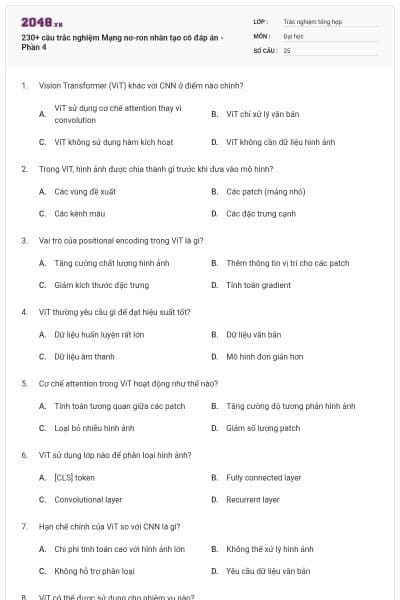

230+ câu trắc nghiệm Mạng nơ-ron nhân tạo có đáp án - Phần 4

25 câu hỏi

Vision Transformer (ViT) khác với CNN ở điểm nào chính?

ViT sử dụng cơ chế attention thay vì convolution

ViT chỉ xử lý văn bản

ViT không sử dụng hàm kích hoạt

ViT không cần dữ liệu hình ảnh

Trong ViT, hình ảnh được chia thành gì trước khi đưa vào mô hình?

Các vùng đề xuất

Các patch (mảng nhỏ)

Các kênh màu

Các đặc trưng cạnh

Vai trò của positional encoding trong ViT là gì?

Tăng cường chất lượng hình ảnh

Thêm thông tin vị trí cho các patch

Giảm kích thước đặc trưng

Tính toán gradient

ViT thường yêu cầu gì để đạt hiệu suất tốt?

Dữ liệu huấn luyện rất lớn

Dữ liệu văn bản

Dữ liệu âm thanh

Mô hình đơn giản hơn

Cơ chế attention trong ViT hoạt động như thế nào?

Tính toán tương quan giữa các patch

Tăng cường độ tương phản hình ảnh

Loại bỏ nhiễu hình ảnh

Giảm số lượng patch

ViT sử dụng lớp nào để phân loại hình ảnh?

[CLS] token

Fully connected layer

Convolutional layer

Recurrent layer

Hạn chế chính của ViT so với CNN là gì?

Chi phí tính toán cao với hình ảnh lớn

Không thể xử lý hình ảnh

Không hỗ trợ phân loại

Yêu cầu dữ liệu văn bản

ViT có thể được sử dụng cho nhiệm vụ nào?

Phân loại hình ảnh

Phát hiện đối tượng

Phân đoạn hình ảnh

Tất cả các nhiệm vụ trên

Tập dữ liệu nào thường được sử dụng để huấn luyện ViT?

ImageNet hoặc JFT-300M

MNIST

CIFAR-10

MS COCO

Ứng dụng thực tế nào phù hợp với ViT?

Nhận diện bệnh lý trong hình ảnh y tế

Phân tích cảm xúc văn bản

Dự đoán thời tiết

Nhận diện giọng nói

Transfer Learning thường được áp dụng khi nào?

Khi có lượng dữ liệu lớn và thời gian huấn luyện không giới hạn

Khi dữ liệu mới hạn chế và tác vụ tương tự tác vụ gốc

Khi không cần mô hình được huấn luyện trước

Khi dữ liệu hoàn toàn không liên quan

Trong Transfer Learning, tại sao các lớp đầu tiên của CNN thường được giữ nguyên?

Vì chúng trích xuất đặc trưng cấp thấp như cạnh, góc

Vì chúng có ít tham số hơn

Vì chúng không ảnh hưởng đến hiệu suất

Vì chúng dễ huấn luyện hơn

Khi fine-tuning, thường điều chỉnh những lớp nào?

Các lớp đầu tiên của mô hình

Các lớp cuối hoặc lớp fully connected

Toàn bộ mô hình

Chỉ lớp đầu ra

Transfer Learning giúp giảm điều gì trong huấn luyện mô hình?

Thời gian huấn luyện và nhu cầu dữ liệu

Số lượng lớp ẩn

Độ phức tạp của dữ liệu

Kích thước đầu ra

Mô hình BERT là ví dụ về Transfer Learning trong lĩnh vực nào?

Xử lý hình ảnh

Xử lý ngôn ngữ tự nhiên (NLP)

Nhận diện giọng nói

Phân tích dữ liệu thời gian thực

Khi nào nên sử dụng Transfer Learning thay vì huấn luyện từ đầu?

Khi có ít dữ liệu và tác vụ tương tự

Khi có dữ liệu lớn và thời gian không giới hạn

Khi mô hình gốc không hiệu quả

Khi cần tạo mô hình mới hoàn toàn

Vấn đề gì có thể xảy ra nếu fine-tune quá nhiều lớp?

Overfitting trên dữ liệu mới

Underfitting trên dữ liệu gốc

Tăng chi phí tính toán không cần thiết

Mất đặc trưng cấp cao

Transfer Learning có thể áp dụng cho dữ liệu nào?

Hình ảnh, văn bản, âm thanh

Chỉ hình ảnh

Chỉ văn bản

Chỉ âm thanh

Tập dữ liệu nào thường được sử dụng để huấn luyện trước mô hình CNN?

ImageNet

MNIST

CIFAR-10

MS COCO

Ứng dụng thực tế nào phù hợp với Transfer Learning?

Phân loại hình ảnh y tế với ít dữ liệu

Phân tích dữ liệu thời tiết lớn

Tạo âm thanh tổng hợp

Dự đoán giá cổ phiếu

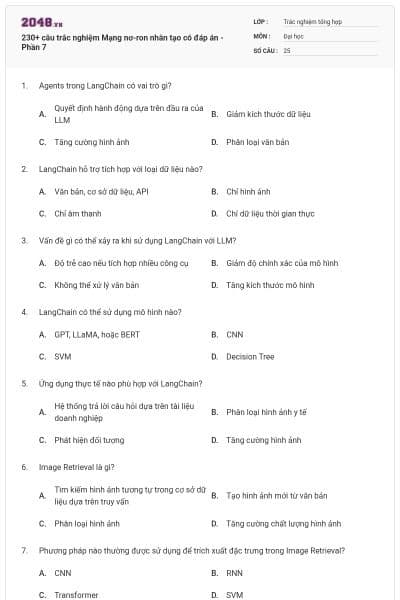

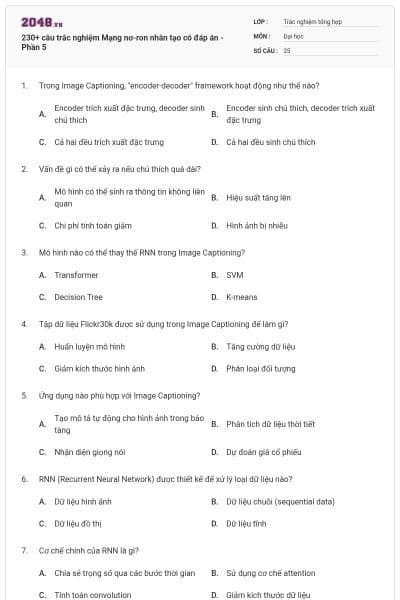

Mục tiêu chính của Image Captioning là gì?

Tăng cường chất lượng hình ảnh

Tạo văn bản mô tả nội dung hình ảnh

Phát hiện đối tượng trong hình ảnh

Phân loại hình ảnh

Phần nào của mô hình Image Captioning xử lý hình ảnh?

CNN

RNN

Transformer

Fully connected layer

Trong Image Captioning, LSTM thường được sử dụng để làm gì?

Trích xuất đặc trưng hình ảnh

Sinh chuỗi văn bản

Tăng cường dữ liệu

Giảm kích thước hình ảnh

Cơ chế attention trong Image Captioning giúp gì?

Tăng tốc độ xử lý hình ảnh

Tập trung vào các vùng quan trọng khi sinh từ

Loại bỏ nhiễu hình ảnh

Giảm số lượng từ trong chú thích

BLEU score được sử dụng trong Image Captioning để làm gì?

Đánh giá chất lượng chú thích

Tăng cường dữ liệu

Tính toán gradient

Giảm kích thước mô hình